| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Round Robin

- DaemonSet

- CloudFormation

- istio

- 정보처리기능사

- SQS

- Lambda

- access_log

- EKS

- 쿠버네티스

- CodeBuild

- AWS

- Kinesis

- S3

- DNS

- server

- 해킹송

- write back

- CloudWatch

- APIGateway

- CodeCommit

- 유나인버거조인트

- 3AZ

- CodePipeline

- ASG

- Kubernetes

- stateful

- cbt

- write Through

- cloudwatch-agent

- Today

- Total

목록분류 전체보기 (46)

cloud bee

AWS cloudwatch-agent로 로깅하기

AWS cloudwatch-agent로 로깅하기

오늘은 ec2 instance에서 발생하는 access log를 cloudwatch-agent로 로그를 수집할 것이다. 해당 다이어그램은 다음과 같다. 블로그 과정에서 필요로 하는 서비스 목록 ✅ Amazon ec2( Amazon Elastic Compute Cloud ) ✅ IAM ( Identity and Access Management ) ✅ Amazon CloudWatch 블로그 실습 조건 ✅ amazon console account ✅ region: ap-northeast-2( 서울 리전 ) Amazon Web Service Steps Step1. Create vpc for 10.0.0.0/16 band Step2. Create a public subnet with availability zon..

csv data athena 쿼리

csv data athena 쿼리

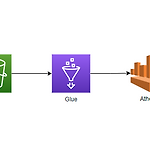

다이어 그램은 위 사진과 같이 구성되어 있다. 총 3가지로 구성할 것이다. 1. S3를 생성하여 demo.csv file을 업로드한다. 2. glue catalog와 glue crawler을 생성하여 실행할 것이다. 3. 이제 크롤링된 데이터를 바탕으로 athena를 통해 쿼리를 진행할 것이다. 우선 먼저 S3를 생성하도록 해주자. windows powershell이나 cmd를 준비하여 rootcsv파일을 통해 "aws configure" 명령어를 통해 사용자 인증을 해주도록 한다. 이제 cmd에서 다음과 같은 명령어를 사용해 S3를 생성하도록 해준다. aws s3 mb s3://demo-korea-s3 이제 S3를 생성하였다면 아래 csv파일을 다운로드하여 S3에 업로드하도록 해준다. amazon we..

캐시 이론정리 write Through, write Back

캐시 이론정리 write Through, write Back

오늘은 write Through와 Write Back에 관한 이론을 한 번 알아볼 것이다. 다른 블로그에서 인용을 하여 이 게시물을 작성하였다. 요약정리한 내용은 아래와 같다. write Back은 write-Behind라고도 불린다. 해당 사진은 Write-Through와 Write-Back를 구분해서 나타낸다. 아래 사진을 참고한다. 이해하기가 어려울 수 있다. 아래 이론을 살펴보고 사진을 다시 보게 되면 이해가 될 것이다. > Write Through란? 우선 CPU가 주기억장치 또는 디스크로 데이터를 기입하고자 할 때 그 데이터는 먼저 캐시로 기입된다. 이때 데이터가 캐시 됨과 동시에 메모리에도 모두 저장된다. 즉 동시에 캐시와 메모리 모두 update와 같이 수행하는 작업이라고 보면 된다. 장점..

Serverless Api test

Serverless Api test

오늘은 아래와 같은 다이어그램으로 amazon web service serverless를 구현해 보았다. 해당 다이어그램에서 사용한 서비스는 아래와 같다. - cloud cloudfront - api gateway - amazon simple storage service(S3) - lambda - Amazon dynamodb 번외로 실제 실습을 진행하면서, "identity and access management(IAM)"도 사용하여 실습을 하였었다. 이 다이어그램으로 실습을 진행하였을 때 어떤 식으로 표시가 되고 동작되는지 알아보도록 하겠다. 우선 나는 이걸 실습을 진행하였을 때 다음과 같은 방법으로 진행하였다. 1. amazon simple storage service(S3) 생성 2. amazon ..

code pipeline 간단하게 구현

code pipeline 간단하게 구현

위에 있는 사진은 해당 실습에서 사용할 아키텍처이다. 해당 아키텍처를 참고하여 codepipeline에 관한 실습을 진행하도록 할 것이다. 목표: codecommit에 업로드된 test.txt를 codebuild를 통해 test.txt 내용물 안에 있는 'a'라는 알파벳을 'ㅁ'으로 치환한 후 S3에 업로드하도록 한다. 우리가 해당 목표를 구현하기 위한 단계이다. 요구사항 1. amazon web service console 계정을 준비한다. 2. 적절한 IAM 권한을 생성해 준다. 3. code commit을 생성한다. 4. S3를 생성한다. 5. codecommit에 test.txt, buildspec.yml을 업로드한다. 6. codebuild를 생성하도록 한다. 7. codepipeline을 생성..

3AZ VPC를 cloudformation을 통해 생성

3AZ VPC를 cloudformation을 통해 생성

amazon web service에서 인프라 서비스를 구축하고자 할 때, 멀티 가용영역(availability zone)을 활용하여 구축하는 경우가 많다. 보통 region안에 2개의 가용영역(availability zone)을 사용하거나 3개의 가용영역(availability zone)을 사용한다. amazon web service 공식문서에는 2개의 AZ(availability zone)를 가지는 VPC를 생성하는 예제가 있으나, 3개의 AZ(availability zone)를 가지는 VPC를 생성하는 예제는 보이지 않았다. 그래서 나중에 편리하게 참고하고자 3개의 AZ(availability zone)를 가지는 VPC를 생성하도록 할 것이다. 해당 VPC stack을 생성하기에 앞서 나는 AWS E..

수업시간 빨리가게 하는방법

수업시간 빨리가게 하는방법

1. 잠을 잔다 잠을 잔다. 하지만 잠은 체감상 4배 더 느리게 흐르는데 왜 자는지 이해가 잘 안 되실 수도 있다. 하지만 체감상 4배가 더 느리게 흐르지만, 한번 잠에 들기 시작하면 쥐도 새도 모르게 수업이 끝나가 있을 것이다. 참 유용하다. 추천 아이템으로는 인형을 추천한다. 사진에 있는 인형은 제주도 갔을 때 샀던 인형이다. 무려 29000원이다. 2. 멍을 때린다. 멍 때리는 것 같은 경우도 아주 좋은 케이스이다. 멍을 때리면서 여러 가지 상상을 하자. 그러면 어느 순간 시간이 많이 흐를 것이다. 멍을 때리다 보면 중간에 짜증 날 때가 있을 수도 있다. 이럴 때, 잠을 자서 체력을 보충해 주도록 하자. 비슷한 예론 명상이 있다. 체력 회복이 매우 잘된다는 효과가 있다 3. 몰래 스마트폰을 한다. ..

kinesis data analyfice flink 실습

kinesis data analyfice flink 실습

나는 해당 깃허브와, AWS 공식문서를 통해 실습을 진행하였다. 데이터 스트림을 소스 및 싱크로 사용하여 flink용 kinesis data analytics를 생성하였다. https://github.com/aws-samples/amazon-kinesis-data-analytics-flink-starter-kit GitHub - aws-samples/amazon-kinesis-data-analytics-flink-starter-kit: Amazon Kinesis Data Analytics Flink Starter Kit helps you Amazon Kinesis Data Analytics Flink Starter Kit helps you with the development of Flink Applic..

AWS EKS에서 EFS 기능 구현하기

AWS EKS에서 EFS 기능 구현하기

오늘은 EKS에서 EFS 기능을 구현할 것이다. https://beecloud.tistory.com/7 AWS EKS 실습 입문( EKS 생성&연결, 도커 이미지 작성) 오늘은 EKS를 실습해보도록 한다. 우선 EKS를 시작하기전에 VPC, 서브넷, 라우팅 테이블, 인터넷 게이트웨이, 보안그룹 등 기본적인 네트워킹 설정을 한다. vpc.yml 파일로 stack을 작성하고 cloudformation beecloud.tistory.com 위 링크에서 생성하였던 instance를 통해 cluster를 사용할 것이다. 우선 CSI를 사용하기 위해 정책부터 생성하도록 한다. curl -o iam-policy-example.json https://raw.githubusercontent.com/kubernetes-s..

AWS EKS 실습 입문( EKS 생성&연결, 도커 이미지 작성)

AWS EKS 실습 입문( EKS 생성&연결, 도커 이미지 작성)

오늘은 EKS를 실습해 보도록 한다. 우선 EKS를 시작하기 전에 VPC, 서브넷, 라우팅 테이블, 인터넷 게이트웨이, 보안그룹 등 기본적인 네트워킹 설정을 한다. vpc.yml 파일로 stack을 작성하고 cloudformation을 통해 VPC를 생성하도록 한다. 아래는 vpc.yml에 기입할 내용이다. vpc.yml을 생성하고 파일 내용 안에 아래 코드들을 복붙 한다. Description: This template deploys a VPC, with a pair of public and private subnets spread across two Availability Zones. It deploys an internet gateway, with a default route on the publi..